L'IA générative n'en finit pas de générer des initiatives dans tous les domaines, ce qui conduit les entrepreneurs à tester des limites qui ne sont pas seulement techniques, mais aussi éthiques.

Ainsi, est-il vraiment possible d'espérer que l'Artificial General Intelligence (AGI) surgisse sous le seul effet du gigantisme poussé toujours plus loin ? Est-il possible de mettre toujours plus prématurément sur le marché des produits qui intègrent l'IA en misant sur les retours des utilisateurs pour les finaliser ? Est-il raisonnable d'entreprendre de créer des robots toujours plus sophistiqués, pilotés par des IA qui restent encore à ce jour des boîtes noires ? Faut-il accepter que nos systèmes d'armement intègrent des IA toujours plus autonomes, au point que l'humain sorte de la boucle ?

NB : Ce billet a été rédigé début juin par un humain et non une boîte de conserve, et publié dans le numéro #264 de Programmez! de juillet 2024.

"WINTER IS COMING"?

Dans son incontournable ouvrage Deep Learning in Python (2nd Edition), François Chollet commence par rappeler l'histoire de l'IA. Le créateur de Keras en souligne le caractère chaotique, l'enthousiasme suite à une découverte se dégonflant comme un soufflé, jusqu'à faire bientôt faire douter que l'IA puisse apporter quelque chose. Ainsi, il y eut deux grands "hivers", l'un après l'IA symbolique, l'autre après les systèmes experts. Pour cette raison, il appelle à la prudence : "We may be currently witnessing the third cycle of AI hype and disappointment, and we're still in the phase of intense optimism".

On est alors en 2021, et ChatGPT n'a donc pas encore stupéfait le monde. Toutefois, le conseil méritait d'être noté, ne serait-ce que pour comprendre pourquoi il commence à être question de winter ces derniers temps.

Fin mars, Sequoia Capital, l'un des plus gros VC de la Silicon Valley, organise une petite sauterie sur le thème The AI Opportunity. Lors du propos introductif, Sony Huang résume crûment la situation : "We spent about 50 billion dollars on Nvidia GPUs just last year and everybody's assuming if you build it, they [les clients] will come. AI is a field of dreams. But so far, we've identified about 3 billion dollars or so of AI revenue, plus change from the cloud providers. We've put 50 billion into the ground, plus energy, plus data center costs and more, and we've gotten 3 out. And to me that means the math isn't mathing yet. The amount of money it takes to build this stuff has vastly exceeded the amount of money coming out so far. So we got some very real problems to fix." Bref, c'est la question du retour sur investissement qui est posée.

Mi-mai, The Economist évoque lui aussi l'apparence d'un surinvestissement dans les infrastructures, mais pour une autre raison. Constatant les sommes astronomiques actuellement investies dans les datacenters par les acteurs de l'IA, l'hebdomadaire rappelle que miser sur les infrastructures en présumant de l'usage qui en sera fait est un pari risqué : il a fallu changer les premiers rails pour les adapter au trafic ferroviaire une fois qu'il s'est développé ; les gens n'ont pas voulu payer le câble posé jusqu'à leur porte pour se connecter à Internet. Partant, les datacenters qui poussent comme des champignons conviendront-ils ? "All the signs are that big tech has succumbed to irrational exuberance", juge The Economist, qui pointe plusieurs risques conjugués : l'explosion des coûts d'exploitation des infrastructures pour faire tourner des modèles toujours moins rentables, car toujours plus nombreux tandis qu'ils s'améliorent toujours moins, rendements décroissants oblige.

Ah ! la question du plateau... C'est qu'il n'y a pas que les investisseurs qui commencent à se demander si l'on n'assiste pas sinon au début de la fin, du moins à la fin du début. Début mai, "Has Generative AI Already Peaked?" s'interroge le très pédagogique Mike Pond de l'excellente chaîne Computerphile. La question lui est inspirée par un papier, dont l'on résumera le titre à No "Zero-Shot" Without Exponential Data, qui affirme, expériences et non spéculations à l'appui - ce pourquoi Mike Pond l'a retenu -, que la relation entre la quantité de données avec lesquelles il faut entraîner un modèle et le niveau de performance que cela lui permet d'atteindre sans plus rien faire - d'où l'expression "Zero-Shot" - n'est pas linéaire, mais exponentielle. Bref, parvenu à un certain stade de l'apprentissage par ingurgitation, l'on a beau gaver le modèle de données, ce gros bêta reste sur un plateau.

De fait, il faut dire les choses comme elles sont : mi-mai, la sortie de GPT-4o a comme jeté un froid. The Economist, dans l'article précédemment évoqué, le relève sévèrement : "it was not the brand new GPT-5 that some wonks had hoped for". Focalisée sur l'actualité du milieu, la chaîne AI Explained salue la sortie de ce nouveau modèle tant attendu, non sans relayer la critique de Gary Marcus, un psychologue qui aime bien faire parler de lui, faisant l'hypothèse qu'OpenAI affronte le plateau, et la réponse d'un responsable d'Open AI à cette pique : "remind me in 6 months". Il faut dire qu'à l'occasion de l'édition 2024 de Microsoft Build, le CTO de la firme de Redmond, flanqué du CEO d'Open AI, a maintenu l'hypothèse d'une évolution exponentielle de la performance des modèles, et évoqué la sortie d'un modèle géant - si GPT-4 est un orque, ce serait une baleine - dans les dix mois.

Après, comme le fait remarquer le développeur de l'hilarante et pertinente chaîne Fireship, force est de constater que "it's been over a year since GPT-4 and unfortunately, I still have a job". Et de rajouter que "making models faster and cheaper is great, but if they're not becoming more intelligent, then singularity is nowhere in sight". Or comme l'on a visiblement alimenté les modèles avec toutes les données possibles, à moins d'une rupture technologique, "it sure looks like we're standing on the edge of a plateau and the only place to go is the trough of disillusionment".

Mais quand bien même un plateau serait atteint, faudrait-il pour autant prédire que l'étape d'après, ce serait le précipice ? Pour OpenAI, ce serait peut-être effectivement la roche Tarpéienne, pour avoir trop fait rêver les spéculateurs avec l'AGI. Pour les autres, non.

Le fait est que même sans AGI, l'IA à base de deep learning, ça marche plutôt pas mal selon le domaine et selon le niveau de tolérance à l'erreur - difficile de fiabiliser un système dont on ignore encore la manière dont il fonctionne -, et qu'au pire, à défaut de progrès technique, il est toujours possible de restreindre le domaine jusqu'à passer sous ce niveau - sans doute, cela fait moins rêver, car ce n'est plus qu'une partie du domaine qui peut être automatisée, mais il se peut qu'une étude de rentabilité démontre que c'est toujours ça de pris.

Bref, en raison des multiples applications qu'elle permet déjà, l'IA à base de deep learning est là pour rester, et personne ne pleurera OpenAI, et surtout pas son generalissimo, si l'entreprise, victime de son hubris, vient à disparaître. En matière de progrès technique, on ne jette jamais le bébé avec l'eau du bain. Eh ! personne ne se souvient de Netscape, mais tout le monde utilise un navigateur...

"FAKE IT UNTIL YOU MAKE IT!"

A vrai dire, comment ne pas être déçu par certaines annonces, qui viennent rompre la cadence de cette belle marche vers l'automatisation généralisée ? La leçon de Theranos - vous savez, la fille condamnée à casser des cailloux pour avoir prétendu lire votre santé dans une goutte de sang - semble n'avoir pas porté : le "fake it until you make it" reste plus que jamais la devise de bien des entrepreneurs pressés de faire fortune dans la Silicon Valley. Ainsi, plusieurs, et non des moindres, se sont fait publiquement taper sur les doigts pour avoir sinon trompé sur la marchandise - la définition de celle-ci est justement une des facettes du problème -, du moins l'avoir présentée à grand renfort d'arguments spécieux, voire fallacieux.

Grosso modo, comme rapporté dans une précédente chronique, le phénomène semble avoir commencé début décembre avec la vidéo de Google présentant Gemini, que TechCrunch a dénoncée pour ce qu'elle était, c'est-à-dire un fake. De là, vigilance de ceux qui débusquent et / ou fuite en avant de ceux qui enfument, d'autres cas ont défrayé l'actualité.

Début avril, la chaîne Internet of Bugs se penche sur le cas de Devin, l'outil de Cognition que son junior de CEO a présenté mi-mars comme "the first AI software engineer" dans une vidéo qui pour le moins a fait le buzz. La dissection méticuleuse de ladite vidéo fait ressortir un écart majeur entre ce que Devin est censé faire - une demande exprimée sur Upwork - et ce qui lui est réellement demandé - les prompts saisis par Cognition. De plus, il s'avère que Devin ne corrige pas les erreurs qu'il trouve dans le code qu'il lui est demandé d'analyser, mais dans celui qu'il génère. Aussi, Devin génère un fichier qui ne devrait pas exister, et par-dessus le marché y stocke du code qui contient des erreurs. Et ainsi de suite, tout est à l'avenant. Sur cette base, Internet of Bugs en conclut que Devin, "this is a lie".

Pour rester dans le domaine de l'automatisation du développement, toujours début mai, GitHub annonce fièrement GitHub Copilot Workspace, "the Copilot-native developer environment". L'annonce n'échappe pas à Theo - t3.gg, qui entreprend à son tour sur sa chaîne une dissection chirurgicale de la vidéo qui, ici encore, fait le buzz. Et rebelotte, mais cette fois sur un ton hilarant, Theo - t3.gg dénonce le verbiage du discours marketing ("there as so many rich words here that are crazy"), l'absence d'intégration avec les autres outils ("that is the magic of the GitHub treadmill as I like to call it, where they just keep running into some new idea instead of fixing the things they built in the past"), l'expression inutile de besoins ("honestly, this kind of feels like your usual like beginner trying to commit things where they just like touch 15 things they shouldn't"), le cherry picking dans les captures d'écran ("they trimmed the screenshot hoping people wouldn't notice that it made two markdown changes that it shouldn't have"), etc. Pour finir, Theo - t3.gg s'interroge "Dear GitHub, Why Did You Release This?", et nous avec lui...

Début mai, Android Authority rapporte une trouvaille : le Rabbit R1, cet assistant IA carré, abricot et bavard censé remplacer le smartphone, n'est pas doté d'un système d'exploitation à part entière, rabbit OS, comme proclamé. En fait, ce n'est probablement qu'une app qui tourne sur ASOP, une version dépouillée d'Android. Comme dans les cas qui viennent d'être rapportés, Android Authority ne s'est pas contenté de jeter un œil sur le patient, mais l'a disséqué... jusqu'à parvenir à déployer l'APK sur un bête smartphone Android ! Fureur de Rabbit, rapporte Ars Technica, qui en est venu aux menaces - la chose à ne pas faire quand on est pris la main dans le pot de confiture.

Entre tous, le cas du Rabbit R1 est vraiment intéressant, car il s'agit d'un produit physique qui a été livré à des clients et non d'une seule vidéo d'annonce d'un produit à venir. Il incarne donc potentiellement la mise en œuvre du "fake it until you make it" menée jusqu'à son terme. En effet, le problème n'est pas seulement que ce qui se passe sous le capot n'est pas ce qui avait été annoncé, mais que plus généralement, c'est tout le produit qui déçoit.

Ainsi, fin avril, Marques Brownlee teste le Rabbit R1. "Barely Reviewable" juge sévèrement le YouTuber, pourtant l'incarnation de ce qu'en Poitou-Charentes l'on désignerait par "coolitude". Sondé sous tous les angles, le gadget en prend pour son grade : ça hallucine quand ça répond, ça vide sa batterie quand ça ne fait rien, ça manque de fonctionnalités de base, ce n'est pas tactile quand il le faudrait, etc.

Pour finir, Marques Brownlee prend du recul et en vient à soulever LA question : "What are we doing here?". Le problème, il explique, c'est que "a lot of theses tech companies are developing tech kinda backwards", c'est-à-dire que "it feels like it used to just be: make the thing and then put it on sale. Now, it's like: put in on sale, and then deliver the half-backed thing, and then iterate and make it better, and hopefully with enough updates, then it's ready, and it's what we promised way back when we first started selling it".

C'est un fait, après les avoir pris pour des collaborateurs au prétexte de leur faire faire des économies - rappelons qu'au fast food, c'est vous qui débarrassez la table, et contre toute évidence, comme l'on dit en sociologie, cela ne va pas de soi -, les entreprises semblent désormais, au prétexte de mieux tenir compte de leurs retours - faire preuve d'agilité comme elles disent -, vouloir les prendre pour des investisseurs. Bientôt l'auberge espagnole, où le client paie pour consommer ce qu'il apporte ?

Toutes ces critiques sont assez réjouissantes à entendre pour l'auteur de cette chronique, qui a déjà rappelé combien il fallait s'étonner de la manière de faire de start-ups telles que la toujours plus mal nommée OpenAI - désormais, l'on dit d'ailleurs CloseAI -, dont le parti pris, ouvertement assumé par son CEO Sam Altman depuis le début, est de sortir des produits non testés et de les corriger en fonction des retours des utilisateurs, au mépris total des conséquences pour ces derniers - et pour d'autres, impactés par ricochet.

Car lorsqu'un avocat se fait épingler par le juge pour avoir cité une jurisprudence que ChatGPT a hallucinée, tout le monde rigole, mais il ne faut pas perdre de vue qu'au bout du bout, le client du prétendu "maître" prend cher. Plus généralement, comme le pointe parfaitement Internet of Bugs, "what theses lies do, is that they cause non-technical people to believe that AI is far more capable than it is at the moment". Et là, plus personne ne devrait rigoler, car c'est la question du législateur courtisé par les acteurs de l'IA qui est posée, et donc des conséquences pour nous tous - fin avril, Time rapporte que leur lobbying est devenu aussi frénétique que pervers, car "while these companies have publicly been supportive of AI regulation, in closed-door conversations with officials they tend to push for light-touch and voluntary rules". Et c'est sans parler des chefs d'entreprise peu intéressés par ce que leurs salariés font vraiment, qui proclament sur tous les toits qu'il faut déployer l'IA car ça plaît aux marchés - même si le réalisme les conduits dans les faits à se montrer nettement plus prudents.

Bref, c'est la foire, et les bateleurs ne savent plus quoi inventer pour se faire entendre. Avis aux chalands : un homme averti en vaut deux !

"ROBOTS OF DAWN"

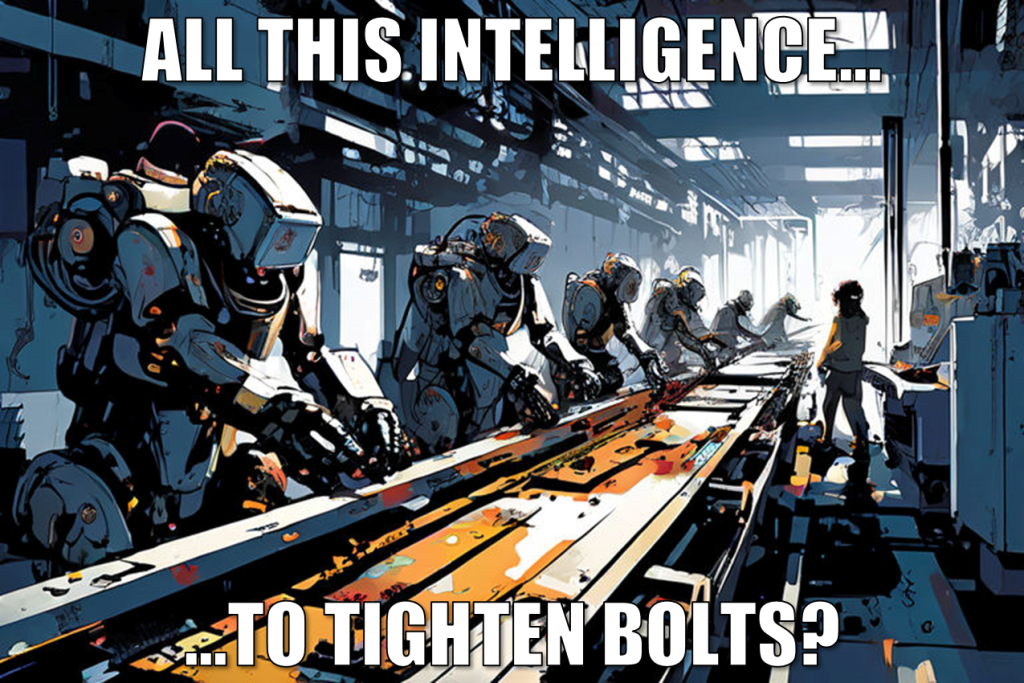

Ces mois derniers, les démonstrations de robots rendus toujours plus capables grâce aux progrès de l'IA se sont multipliées, si bien que l'auteur de cette chronique ne peut plus les ignorer. Florilège :

- Fin avril, Astribot présente l'Astribot S1, un robot vaguement humanoïde - une toute petite tête réduite aux caméras et des bras énormes - qui décapsule une bouteille, plie un t-shirt, arrose une plante, et autres tâches ménagères avec une dextérité étonnante. Point à noter : il fait tout depuis derrière un plan de travail, n'étant visiblement pas mobile.

- Depuis un an déjà, Figure rapporte régulièrement les progrès de son robot Figure 01, pour sa part très humanoïde. Au fil des mois, l'on a ainsi pu voir Figure 01 marcher - pas très élégamment, mais tout de même -, préparer un café à la machine, se saisir d'une cagette et la déposer sur un convoyeur, et converser pour donner une pomme, ranger de la vaisselle, etc. Point à noter : il est présenté comme autonome.

- Mi-avril, Boston Dynamics, qui s'est fait connaître il y a déjà vingt ans avec BigDog, un robot quadrupède, dévoile Atlas, un robot pour sa part très humanoïde. La vidéo fait le buzz, et c'est à juste titre. Atlas allongé qui se lève en accomplissant des contorsions invraisemblables, c'est comme le T-1000 en métal liquide qui change de forme : le décalage entre l'apparence humaine et la prouesse inhumaine fait courir un frisson.

Plus généralement, tous les acteurs de l'IA veulent en être, ce qui donne l'occasion de mieux comprendre ce qui est en train de se jouer.

Ainsi, comme rapporté dans une précédente chronique, mi-mars, à l'occasion du GTC24, le CEO de Nvidia annonce le projet Gr00T, qui vise à développer un foundation model pour la robotique - depuis l'AI Act, on dit "systèmes d'IA à finalité générale" sur nos terres. L'idée, précise Jensen Huang, c'est que "we'll have human examples in articulation form, and AIs will watch us, understand what is happening and try to adapt it for themselves into the context, and because it can generalize with this foundation models, maybe these robots can also perform in the physical world fairly generally". Partant, "the ChatGPT moment for robotics may be right around the corner".

Ce qui fonde en raison le projet, ce sont les apports constatés de l'IA générative en robotique. Toujours à l'occasion du GTC24, Vincent Vanhoucke, en charge du sujet chez Google DeepMind, refait le film dans une présentation remarquable que tous ceux qui ont manqué des épisodes depuis ChatGPT se doivent impérativement de regarder.

Pour résumer, il explique que l'apparition de l'IA générative a été un choc pour les roboticiens : "we suddenly had capabilities like common sense reasoning or understading of the world that had not really been available to us in the past". En effet, à partir du moment où il est possible de demander à un LLM de décrire les étapes à suivre pour préparer un café dans un environnement qu'on lui décrit, pourquoi ne pas passer par là pour planifier les actions qu'un robot doit accomplir pour jouer au serveur ? Et tant que l'on y est, pourquoi ne pas utiliser aussi un VLM en amont pour produire une description de l'environnement sur la base des images captées par la caméra du robot, et un autre LLM en aval pour générer le code qui permet de contrôler ledit robot à partir de la planification ? Enfin, pourquoi ne pas tenter de fusionner tous ces modèles dans un seul ?

On le voit, dans ce domaine comme dans tant d'autres, la mise à disposition d'une boîte noire qui embarque une connaissance du monde, et qu'il est possible de commander à partir de données très brutes - des instructions prodiguées en langage naturel ou des images captées par une caméra - pour qu'elle contrôle un dispositif permet de se dispenser d'un travail fastidieux : plus besoin de chercher à recréer un cerveau à force d'algorithmes compliqués - reconnaissance de formes, traitement du langage naturel, etc. -, il suffit d'en prendre un et de l'entraîner sur la base d'exemples. Le problème, c'est évidemment l'inconnu qui règne sur les capacités et les incapacités réelles de la boîte noire. Elles constituent une sérieuse limite, ce qui implique d'étoffer le système de boucles de rétroaction et autres mécanismes de contrôle.

Plus fort encore, Vincent Vanhoucke montre comment les progrès rapidement accomplis dans cette direction ont conduit à développer Multi-Joint dynamics with Contact (MuJoCo), un moteur de physique qui permet de simuler le fonctionnement d'un robot dans un environnement proche de la réalité, ce qui permet de procéder à des expériences plus rapidement. Aussi, il montre comment ces progrès ont conduit à doter un robot de la capacité à conduire comme une réflexion intérieure, en lui faisant générer une simulation de ce qui pourrait se passer si jamais il devait entreprendre telle ou telle séquence d'actions pour atteindre un certain objectif, et finalement retenir la séquence qui apparaît la plus opportune.

L'idée de la réflexion intérieure apparaît comme un développement de la démarche initiée avec la technique du Chain-of-Thought (CoT), où l'on demande à un LLM de produire une réponse en procédant par étapes sur la base d'un exemple, ce qui produit de meilleurs résultats. Comment est-ce possible ? Dans un intéressant papier intitulé Let's Think Dot by Dot: Hidden Computation in Transformer Language Models, publié en avril dernier, soit deux ans après l'invention de cette technique, des chercheurs rapportent que "it remains unclear to what extent these performance gains can be attributed to human-like task decomposition or simply the greater computation that additional tokens allow". Ce faisant, ils font l'expérience de simplement compléter une demande par "...", et observent dans certains cas des réponses plus intéressantes qu'en mobilisant CoT. Comme "..." est à proprement parler insignifiant, cela incite à penser que c'est plutôt parce que cela prolonge les calculs. Mais cela reste une hypothèse...

En tout cas, à défaut de savoir comment y parvenir implicitement, faire "réfléchir" un LLM explicitement, quitte à s'aider d'un autre, est une piste toujours plus explorée. Ce n'est pas vraiment nouveau, puisqu'à la base des Generative Adversarial Networks (GAN) inventés en 2014, il s'agissait d'entraîner un réseau qui génère une image dans l'objectif de convaincre un autre réseau que cette image n'a pour ainsi dire pas été générée. Depuis l'avènement des LLMs, on a vu des chercheurs recycler cette idée de mettre en concurrence, comme par exemple dans Jailbreaking Black Box Large Language Models in Twenty Queries pour automatiser la recherche de prompts permettant de faire dire à un tchat ce qu'il n'est pas censé dire.

Mais plutôt que de les faire s'affronter, pourquoi ne pas les faire coopérer ? Après tout, peut-être que Two bots are better than one, comme le titre The Economist. Mi-mai, l'hebdomadaire rapporte une série d'expériences conduites en associant des LLMs au sein d'un Multi-Agent System (MAS). Ainsi, la DARPA a fait collaborer les chatbots Alpha, Bravo et Charlie dans une simulation où ils devaient désamorcer des bombes dissimulées. Ou encore, le MIT a découvert que deux chatbots, dont chacun était invité à ajuster sa réponse en fonction de celle de l'autre jusqu'à ce qu'ils parviennent à un consensus, pouvaient mieux résoudre des problèmes de mathématiques qu'un seul. Après, tempère The Economist, un attelage reste coûteux à faire fonctionner et il n'est pas sans risque, comme lorsque les LLMs se renvoient la balle à l'infini, ou sont victimes d'une hallucination collective...

Enfin, pour revenir sur cette idée de simulation, ceux qui n'ont pas de robot chez eux, mais qui veulent néanmoins comprendre comment un LLM peut permettre d'actionner une entité, peuvent toujours se rabattre sur un agent. Il y a un an, une équipe de chercheurs a commis Voyager, un agent qui évolue dans Minecraft en cherchant à produire des objets toujours plus élaborés. L'on y retrouve les composants déjà évoqués : perception, planification et activation. A défaut d'explorer le code mis à disposition sur GitHub, la chaîne Two Minute Papers a produit un bon résumé du papier. A voir !

"THE MILITARY-INDUSTRIAL COMPLEX"

"In the councils of government, we must guard against the acquisition of unwarranted influence, whether sought or unsought, by the military-industrial complex" expliquait Eisenhower dans son célèbre discours d'adieu en 1961, au terme de son second mandat présidentiel. Bon, il est possible que ledit complexe trouve avec l'IA un nouveau levier pour exercer son influence, en surfant sur les craintes des gouvernements.

Début mai, The War Zone rapporte qu'une unité militaire américaine serait sur le point de mettre en service des "robot dogs" équipés de fusils, et bien évidemment d'IA. Ce ne sont pas robots autonomes, au sens où s'ils sont bien capables d'accomplir seuls les missions qu'on leur donne - "tunnel work" et "perimeter security" -, le principe est toujours du "man-in-the-loop" dès lors qu'il s'agit de faire feu.

C'est le dernier développement en date - pour autant qu'il soit possible de le savoir - d'une présence toujours plus front-office de l'IA dans les forces armées. On le sait, cette dernière est déjà utilisée en back-office, tout particulièrement depuis le conflit en Ukraine.

Mi-février de l'année dernière, The Economist avait tracé un portrait intéressant de la situation en pointant deux protagonistes aux noms tirés de Lord of the rings : Palantir et Anduril, entreprises fondées par des personnalités décrites comme plutôt excentriques. Des "Silicon Valley renegades" en tant qu'ils estiment nécessaire que la tech investisse le militaire, ce qui est effectivement est loin d'aller de soi sous le soleil californien. Un article du New York Times cité plus loin rappelle que mi-2018, dans le cadre du projet Maven, un tout petit contrat entre Google et le DoD pour développer une IA permettant d'identifier des cibles avait suscité une révolte dans l'entreprise, au point que Google y avait renoncé. On est aux antipodes de la position du dirigeant de Palantir, dont un article de The Guardian rapporte qu'il a déclaré que "the peace activists are war activists" lors de l'AI Expo for National Competitiveness qui s'est tenue mi-mai à l'initiative d'Eric Schmidt, un des fondateurs de Google...

Si elles en affichent l'esprit ne serait-ce que dans le look de leurs fondateurs, les deux entreprises sont désormais loin d'être des start-ups. Fin mai, Time classe Palantir, désignée comme un "data-mining geant", pami les "100 most influential companies" en 2024. Il faut dire que d'après Wikipédia, son chiffre d'affaires s'est élevé à plus de 2 milliards de dollars en 2023. La même année, toujours selon Wikipédia, celui d'Anduril n'a été en comparaison que d'environ 500 millions de dollars, mais tout de même...

Palantir et Anduril sont sur une trajectoire plus qu'ascendante. Fin mai, DefenseScoop rapporte que Palantir vient de décrocher un contrat de 480 millions de dollars pour un prototype du Maven Smart System, au cœur du projet Maven. Initié en 2017, ce projet visait alors à "accelerate DoD's integration of big data and machine learning", et s'est donc nécessairement étendu au deep learning. Le système évoqué ingurgite les données de multiples sources et identifie des cibles potentielles.

Il faut croire que le DoD y croit, en dépit d'un résultat mitigé en Ukraine. Fin avril, un long article du New York Times constate effectivement qu'identifier des cibles ne vaut que tant que cela est possible, et qu'il est possible de les atteindre. Or les russes excellent désormais dans la guerre électronique, brouillant jusqu'au guidage des HIMARS, tout en faisant monter la pression de leur rouleau compresseur. Conséquence : "when new technology meets the brutality of old-fashioned trench warfare, the results are rarely what Pentagon planners expected.".

Début avril, dans Battling Under a Canopy of Drones, le New Yorker rapporte que confrontés au rationnement des matériels et munitions, les ukrainiens ont entrepris de se débrouiller, en développant notamment toute une industrie du drone kamikaze bon marché, facile à produire en masse. Début juin, The Economist rapporte même que pour contrer le brouillage dont leurs drones sont désormais victimes, les ukrainiens ont poussé l'ingéniosité jusqu'à produire Eagle Eyes, un logiciel qui s'appuie sur l'IA pour guider un drone sur la base de ce qu'il capte via sa caméra et compare à une carte du terrain mémorisée, soit un guidage autonome purement optique.

C'est, pour en revenir à l'article du New York Times, vers le développement d'essaims de tels drones capables de communiquer entre eux même si le contact est perdu avec leurs opérateurs que notamment Eric Schmidt, déjà cité, entend miser. A vrai dire, tout cela n'est pas nouveau. Dans un intéressant ouvrage publié en 2020, sobrement intitulé The Kill Chain: Defending Ameria in the Future of High-Tech Warfare, Christian Brose, qui travaille chez Anduril après avoir longtemps été impliqué dans les affaires militaires au Sénat, plaidait pour une évolution du très lourd appareil administratif militaire afin de favoriser l'innovation, c'est-à-dire financer de petits programmes rapides et non de gros programmes lents, tout particulièrement pour anticiper une menace prenant la forme de "fully autonomous swarms of intelligent combat drones" chinois capables de subjuguer les défenses américaines - bien évidemment vers Taïwan.

D'ailleurs, parlant de drones, c'est autant pour Palantir, car Anduril n'est pas en reste. Fin mai, Wired rapporte que l'entreprise vient de faire la nique à des géants tels que Lockheed Martin et Boeing en étant choisie, parallèlement à General Atomics, pour développer un prototype du Collaborative Combat Aircraft (CCA). Le Fury, puisque c'est le nom choisi par Anduril, devra évoluer en compagnie d'un avion piloté par un humain, ou tout seul comme un grand. Bref, l'IA permettra non plus seulement d'analyser ce que le drone permet de capter, mais de contrôler ce dernier - ce qu'un commentateur qualifie de "big shift" pour l'armée américaine. A cela s'ajoute le "swarming", la possibilité de contrôler un essaim de drones, qu'Anduril entend assurer à l'aide de sa plate-forme Lattice.

Qui a vu l'excellent Eye in the Sky ne peut ignorer que le seul fait d'être aux commandes d'un drone peut soulever d'épineux enjeux éthiques. Que dira-t-on dans le cas d'essaims de drones, par ailleurs rendus autonomes par l'IA ? "Only an alert and knowledgeable citizenry can compel the proper meshing of the huge industrial and military machinery of defense with our peaceful methods and goals, so that security and liberty may prosper together", concluait Eisenhower dans son discours déjà évoqué. Ce qui, à l'heure de la révolution de l'IA, souligne le devoir de chacun de s'éduquer, et donc des Etats d'éduquer...