Si un sujet occupe bien le devant de l'actualité technique, voire de l'actualité tout court, ce sont les progrès accomplis dans l'univers de l'IA, constellation ML, système DL, planète LLM notamment.

Difficile de s'y retrouver pour qui y pose le pied après à un premier contact avec ChatGPT. C'est que ladite planète est en ébullition ; le paysage y change du jour au lendemain. Dès lors, se refaire le film ne pourrait-il pas permettre de se donner quelques points de repère ? Cette petite chronique de temps récents tâchera de s'y employer.

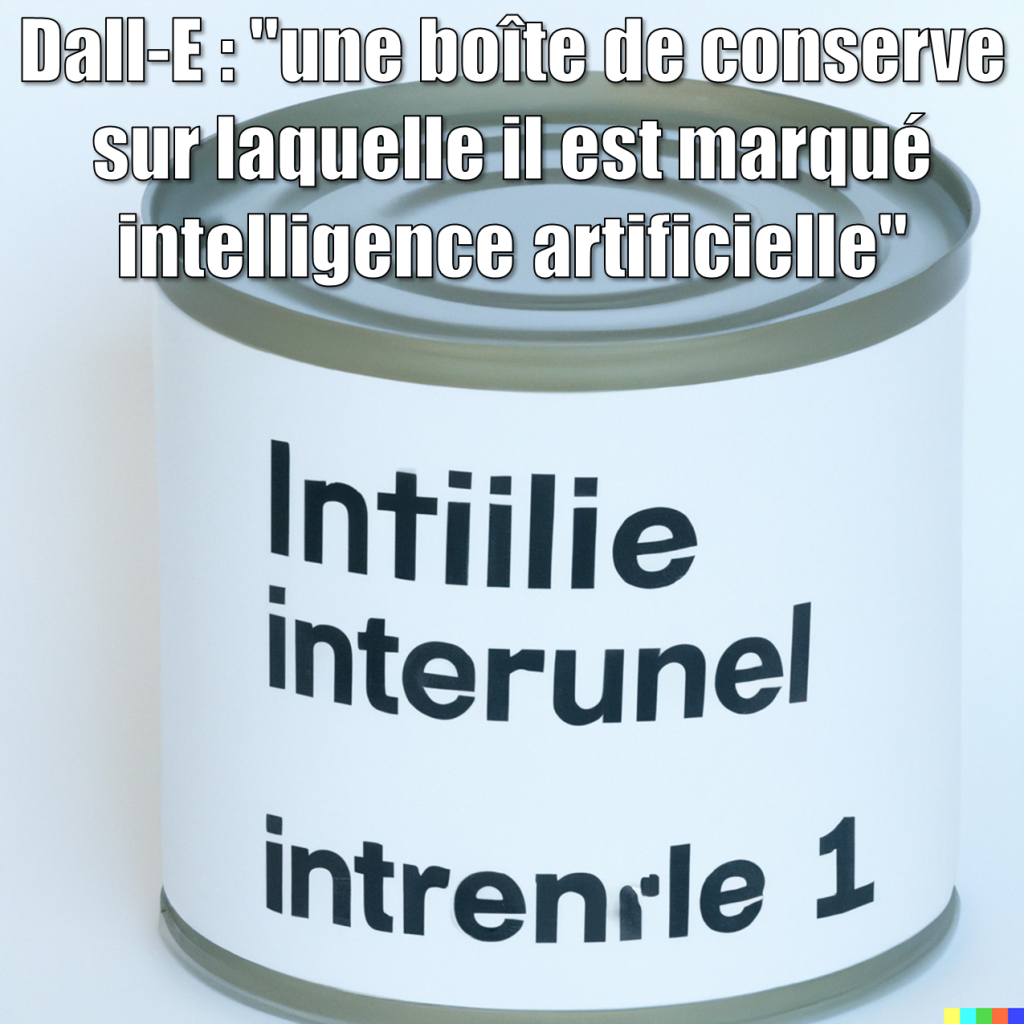

NB : Ce billet a été rédigé en juin par un humain et non une boîte de conserve, et publié dans Programmez! #258 de juillet 2023.

On n'y comprend toujours pas grand-chose, et pour cause

Début mars, la chaîne Computerphile sur YouTube a sollicité Rob Miles pour nous parler un peu des glitch tokens, ces termes qui n'ont pas de sens pour nous mais qui en ont visiblement un pour un LLM, puisque ce dernier génère une réponse quand on lui en fournit un – par exemple, " SolidGoldMagicKarp" avec un espace au début, s'il vous plaît. L'occasion de constater que comprendre pourquoi un LLM se comporte ainsi est un champ de recherche en soi, balbutiant qui plus est. C'est celui de l'interprétabilité.

Les concepteurs de LLM, et plus généralement d'AI génératrices à base de deep learning, ne s'en cachent pas : ils ne savent pas bien, et même pas bien du tout, pourquoi leurs modèles génèrent ce qu'ils génèrent. Le problème ne date pas d'hier. En remontant dans le temps, on en rit presque, quand le sympathique Yann LeCun, qui s'est couvert de gloire grâce à ses travaux sur les convnets, explique lors d'un cours au Collège de France qu'un réseau de neurones très profond comme ResNet, "on sait pas très bien pourquoi, mais ça marche vraiment très bien". Et de passer à la patate chaude à son collègue mathématicien Stéphane Mallat, qui aura fort à faire face à ce que ce dernier appelle "la malédiction de la grande dimension".

Ce que l'on finit par comprendre, c'est que tous ces modèles ne sont pas tant les produits d'une science que d'une ingénierie. La formule n'a rien de méprisant ; elle vise seulement à faire saisir quelque chose de fondamental, à savoir que celui qui produit un modèle est comme un inventeur qui crée une machine en s'appuyant moins sur des théories que sur des expériences. Yann LeCun explique bien cela dans sa conférence The Epistemology of Deep Learning. Une conséquence, c'est que la théorie qui explique le fonctionnement de l'invention peut n'être dégagée que bien après.

Partant, il faut supposer qu'il sera difficile de demander des comptes à OpenAI sur le sujet. D'autant plus qu'à en juger d'après ce que rapporte Ezra Klein, familier des acteurs de l'AI de la bay, dans un épisode de Hard Fork – le podcast tech et rigolo du New York Times – début avril, l'interprétabilité n'est pas au cœur des préoccupations. Citons-le : "The companies are like HUGELY bought in on "let's scale the model" and like a couple of people are working on interpretability". Et pour cause, le business model étant de produire le modèle, pas de l'expliquer. Aussi, début mai, quand OpenAI a annoncé développer un outil pour expliquer le comportement de neurones dans un LLM, c'est sans surprise que ceux qui l'attendaient là ont pu rester sur leur faim...

Il n'en reste pas moins nécessaire de chercher à résoudre ce problème. Après tout, si l'on ne sait pas comment ça marche, comment savoir pourquoi ça ne marche pas – et à la limite pourquoi ça ne semble pas marcher, car si ça se trouve, ça marche comme ça doit marcher, et le problème devient dès lors vraiment un GROS problème !

L'apocalypse ne serait pas pour demain

Certains n'ont pas tardé à redouter que ChatGPT ne dégénère en Skynet. Pour donner la mesure du débat, citons fin mars la tribune d'Eliezer Yudkowsky publié dans Time. Très sobrement intitulée Pausing AI Developments Isn't Enough. We Need to Shut it All Down, elle présente le mérite de n'avoir rien plus à dire que ce qui est dans le titre, et si elle est évoquée ici, c'est surtout parce qu'elle est ainsi parvenue à faire parler d'elle. De fait, a-t-on jamais arrêté le progrès ? Enfin, il faut de tout pour faire un monde, et à l'autre extrême, l'euphorie est sans doute aussi débridée que la dysphorie, ne serait-ce que pour le plaisir d'alimenter la controverse... On y reviendra.

Pour l'heure, avec bien plus de pragmatisme, l'édition de mi-mai de The Economist contient un assez long article sur les effets possibles des progrès de l'IA sur l'emploi. De la lecture de Your job is (probably) safe from artificial intelligence, il faut retenir, pour reprendre les termes de Paul Krugman dans une tribune publiée dans le New York Times fin mars, que A.I. May Change Everything, but Probably Not Too Quickly.

Pour le magazine, chacun devrait garder en tête le constat étonnant fait par l'économiste Robert Fogel : quand le chemin de fer est arrivé, son impact économique n'a été que modeste, car il s'est essentiellement substitué à d'autres moyens de transport. Et si pour expliquer ainsi l'effet de nouvelles technologies par le passé, les économistes peuvent être assez crédibles, ils ont largement démontré qu'ils le sont beaucoup moins, voire pas du tout, pour prédire celui qu'elles pourraient avoir à l'avenir.

La raison en est que ces technologies prennent beaucoup de temps à se diffuser jusqu'à affecter le travail, ne serait-ce que parce qu'il faut composer avec la régulation, tout particulièrement politique : après tout, "only the bravest government would replace teachers with AI". Cela laisse tout le temps requis pour créer de nouveaux emplois qui remplacent ceux qui disparaissent. Autrement dit, les gens ne feront plus demain la même chose qu'ils font aujourd'hui, et voilà tout. Pour compléter le tableau, l'AI ne fera pas tout. Si un LLM pourra assister un plombier, c'est à ce dernier qu'il reviendra de résorber de la fuite in fine, raisonnement à appliquer dans bien des domaines.

La nouvelle fera chaud au cœur de ceux qui ont pu être alarmés par diverses annonces, tout particulièrement celle de HAL + 0x010101 = IBM qui, le jour même de la fête du Travail, a fait savoir à Bloomberg News qu'elle songeait faire une pause sur les recrutements au titre que 7 800 emplois pourraient être remplacés par l'IA dans les trois ans, tout particulièrement dans les activités de back office – les RH sont citées, mais à vrai dire, dans l'informatique, à quoi les RH ont-elles jamais servi ?

Des tchats à la veux-tu en voilà

Début mars, c'est la stupéfaction : le LLaMA s'est échappé dans la nature ! LLaMA, c'est un LLM créé par Meta, qui fin février a mis à disposition de tous le modèle, réservant sur demande aux chercheurs l'accès au vocabulaire à base de tokens ainsi qu'au checkpoint, autrement dit les valeurs des paramètres qui sont le produit d'un apprentissage nécessitant des moyens considérables. Un excellent mémo de Google – sur lequel on reviendra – rapporte comment lesdits poids ont évidemment fuité dans la semaine, pour se retrouver plein partout dans la nature. Dès lors, comme l'écrit Google, "the impact on the community cannot be overstated". C'est que la grande foire aux LLM a été déclarée ouverte, pour deux raisons.

La première raison, c'est que des petits malins ont trouvé le moyen de faire tourner le modèle sur l'ordinateur, et bientôt le smartphone, puis le Raspberry de Monsieur tout-le-monde, notamment en appliquant une opération dite de quantization pour réduire la précision des calculs sans que cela ne dégrade vraiment la pertinence de leurs résultats. La seconde raison, c'est qu'un modèle peut toujours être ajusté : c'est le fine-tuning, qui consiste à lui rajouter des couches et à l'entraîner en n'ajustant que les poids de ces dernières pour aboutir à un modèle spécialisé. Or en cette matière, d'autres petits malins ont trouvé le moyen d'entraîner des modèles dérivés de LLaMA pour un budget ridicule et en un rien de temps.

Depuis, ce n'est plus que tchats à la veux-tu en voilà : Alpaca, Vicuna, GPT4All, etc. Google avait bien besoin de cela ! Déjà pointé du doigt pour s'être fait doublée par OpenAI qui, ironie de l'histoire, s'est largement appuyée sur les travaux en matière d'IA qu'elle a diffusés très libéralement, la firme de Mountain View a littéralement ramé pour sortir en catastrophe un Bard qui a été très mal reçu. Pour en rajouter, début mai, le mémo dont il a été question a fuité, qui donne bien la mesure du désarroi : We Have No Moat, puisque tel est son titre, le seul réconfort résidant dans le sous-titre And neither does OpenAI...

Les régulateurs au boulot

Fin mars, prétendant constater comme un emballement, un certain nombre de personnalités, dont Elon Musk, signent une lettre ouverte appelant à une pause dans le développement d'IA plus puissantes que Chat GPT. Quelques mois plus tard, lors d'un entretien qu'Elon Mush accorde à CNBC, le journaliste lui demande s'il est préoccupé par le fait que l'IA pourrait détruire l'Humanité. Evoquant cette lettre, l'entrepreneur s'exclame : "I knew it would be futile. Call it like... It's one of those things "well for the record I recommanded that we pause". Did I think there would be a pause? Absolutely not!", avant d'éclater de rire.

Va-t-on en rester là ? Pas dit. Pour ce qui concerne les US, la veille, Sam Altman a été appelé à témoigner devant un comité du Sénat. Analysant l'audition dans un épisode de Hard Fork, les journalistes du New York Times constatent que cette réactivité des sénateurs à l'actualité de la tech est tout à fait inédite. Pour une fois, ce ne serait pas attendre de constater les dégâts pour agir, comme cela a été notamment le cas avec les médias sociaux ? A voir, et comme le souligne un des journalistes, une régulation peut parfaitement échouer. Sans compter que certains accusent déjà Sam Altman de préempter le débat pour imposer des règles qui profiteraient surtout à OpenAI. Il est vrai qu'au court de l'audition, le ton était à ce point cordial qu'un vénérable a demandé à l'impétueux quelle régulation il suggérerait, avant de lui proposer de siéger dans l'agence de régulation suggérée en réponse...

Sur le vieux continent, les régulateurs effectifs ou potentiels ont aussi entrepris de se faire entendre des acteurs de la tech, mais plutôt sur le ton du bruit de bottes que sur celui de la lyre. Fin mars, l'Italie a proprement interdit l'accès à ChatGPT, craignant que l'outil ne préserve pas assez les droits des utilisateurs sur leurs données personnelles. Accès rétabli un mois plus tard, après qu'OpenAI a pris des mesures en conséquence – lesquelles, on ne sait toujours pas.

En France, la Cnil s'est aussi fait entendre, mais sur un autre ton. Fin mai, elle a publié un plan d'action pour un déploiement de systèmes d'IA respectueux de la vie privée des individus qui annonce un florilège de dispositifs – règles et accompagnements – à venir. La Cnil insiste sur le fait qu'elle ne découvre pas le sujet, et qu'elle souhaite travailler dans un esprit de dialogue avec les acteurs du domaine. Cette ouverture est de bon aloi : en démocratie, il y a autre chose à faire pour protéger les gens contre un danger qui les menace que de commencer par les punir. Dans un autre domaine, l'expérience de ces dernières années a démontré à l'envi qu'il n'y a rien bon à s'aligner sans réfléchir sur les sursauts autoritaires romains...

Mille milliards de dollars

Le montant qui fascinait Patrick Dewaere au point d'en faire un scandale à la une relève aujourd'hui de l'ordre de la banalité. Fin mai, Nvidia rejoint le club des entreprises dont la valorisation atteint le trillion de dollars. La performance fait suite à l'annonce de profits records et d'une révision des plus optimistes de ceux à venir.

Comme rappelé dans la foulée dans un épisode de Hard Fork, Nvidia engrange les fruits d'un pari à l'époque jugé risqué par certains de ses investisseurs, celui qu'il serait possible de faire la nique au CPU en imposant le GPU dans le domaine du calcul scientifique. Par deux fois, l'histoire a déjà donné raison au fabricant de chips à l'occasion de deux fredaines qui ont viré à la frénésie : les cryptomonnaies, et le deep learning.

Le même jour, sous le titre The Next AI Moment is here, Jensen Huang fait son show au COMPUTEX 2023. Devant le ban et l'arrière-ban de l'électronique taïwanaise, le sémillant CEO du nouvel empire ne manque pas de remercier avec profusion ceux qui utilisent en pagaïe ses GPU pour construire les briques de data centers qui donnent accès à des capacités de calcul monstrueuses – on parle d'exaflop, là. Et de proclamer l'avènement de ce qu'il décrit comme rien de moins qu'un new computing model, celui de l'accelerated computing où chacun utilise des services bâtis sur ces data centers par les grand hébergeurs, pour entraîner des IA. Soit pour le résumer : "the GPU server is no longer the computer, the computer is the data center".

Devant un tel étalage, le doute le dispute toutefois un peu à la fascination. Ce qu'il est arrivé avec LLaMA ne tend-il pas à démontrer qu'il serait possible d'obtenir de bons résultats à moindre frais ? Et comme le fait remarquer François Chollet dans son ouvrage à juste titre érigé en bible, Deep Learning in Python, ne risque-t-on pas d'être engagé dans ce qu'en sociologie, l'on désigne comme une dépendance de sentier ? :

You could say that modern deep learning is the product of a co-evolution process between hardware, software, and algorithms: the availability of NVIDIA GPUs and CUDA led to the early success of backpropagation-trained convnets, which led NVIDIA to optimize its hardware and software for these algorithms, which in turn led to consolidation of the research community behind these methods. At this point, figuring out a different path would require a multi-year re-engineering of the entire ecosystem.

Et Ghost in the Shell ?

Cette chronique ne serait pas complète si elle n'évoquait pas la résurgence du sempiternel débat sur la nature de l'intelligence de l'IA, certains allant jusqu'à se demander s'il n'y a pas conscience.

A vrai dire, c'est une purge, car ces débats n'intéressent guère l'auteur de ces lignes. Pour lui, l'Homme peut penser qu'il est Homme parce qu'il peut avoir conscience de se penser comme tel – une interprétation abusive du Je pense, donc je suis de Descartes –, ce n'est pas suffisant pour définir ce qu'il est. En effet, ne le pourrait-il pas qu'il n'en serait pas moins Homme, sans qu'il soit nécessaire de préciser ce qu'il faut entendre par là. L'Homme est au-dessus de tout, et il n'a pas à le justifier. En matière d'humanité de la Machine, il juste hors de question d'ouvrir la boîte de Pandore qui ferait un jour sombrer dans une controverse à la Valladolid.

Cela ne veut pas dire que l'IA ne va pas nous étonner par ses capacités qui dépasseront peut-être un jour toutes celles de l'Homme. On le comprend en écoutant Sam Altman dans un entretien qu'il accorde à Lex Fridman : la perspective est bien celle d'une AGI, c'est-à-dire d'une Artificial General Intelligence. Et à en juger par un autre des propos d'Ezra Klein, dans l'épisode de Hard Fork déjà mentionné, cette position n'apparaît pas du tout isolée. Evoquant la culture dans le champ de l'IA, il explique que "they really think – a lot of them, this is not true for all but I'm talking about people a the TOP of the companies, they really think they're inventing the next stage in intelligence evolution, right? The God machine".

Au regard de l'ambition, ce dont il faudra tenir compte, pour reboucler sur la nécessité d'une régulation, c'est combien un esprit de revanche anime tous ces gens. Citons Sam Altman – mais Yann LeCun aussi y est allé de sa pique –, dont le propos est assez frappant pour que Lex Fridman l'ait repris pour teaser :

You know, like, I remember at the time an eminent AI scientist at a large industrial AI lab was, like, individual reporters being, like, you know, "these people aren't very good" and "it's ridiculous to talk about AGI and I can't believe you're giving them time of day". And it's like... That was the level of, like, pettines and rancor in the field at a new group of people saying "we're gonna try to build AGI". [...] We don't get mocked as much now.

A coup sûr, Sam Altman, comme bien d'autres, doit écouter Revenge de Daniel Pemberton le matin en se rasant. Cela, les sénateurs qu'il courtise, au point qu'ils voient plus en lui le Pygmalion que le Dr. Frankenstein, auront tout intérêt à le méditer...